- লেখক Lynn Donovan [email protected].

- Public 2023-12-15 23:44.

- সর্বশেষ পরিবর্তিত 2025-01-22 17:19.

1) ছোট ফাইল সমস্যা ভিতরে এইচডিএফএস : অনেক সঞ্চয় ছোট ফাইল যা অত্যন্ত ছোট ব্লক আকার দক্ষতার দ্বারা পরিচালনা করা যাবে না তুলনায় এইচডিএফএস . মাধ্যমে পড়া ছোট ফাইল ডেটা নোড থেকে ডেটা নোডের মধ্যে প্রচুর অনুসন্ধান এবং প্রচুর হপিং জড়িত, যা অদক্ষ ডেটা প্রসেসিংকে পরিণত করে।

এর পাশাপাশি, কোন ফাইলগুলি Hadoop এ ছোট ফাইলের সমস্যাগুলির সাথে মোকাবিলা করে?

1) HAR ( হাডুপ সংরক্ষণাগার) নথি পত্র সাথে পরিচয় করিয়ে দেওয়া হয়েছে ছোট ফাইল সমস্যা মোকাবেলা করুন . HAR উপরে একটি স্তর চালু করেছে এইচডিএফএস , যা জন্য ইন্টারফেস প্রদান করে ফাইল অ্যাক্সেস করা ব্যবহার হাডুপ সংরক্ষণাগার কমান্ড, HAR নথি পত্র তৈরি করা হয়, যা একটি চালায় মানচিত্র কমাতে কাজ প্যাক নথি পত্র মধ্যে আর্কাইভ করা হচ্ছে ছোট সংখ্যা HDFS ফাইল.

উপরন্তু, আমি কি HDFS-এ একাধিক ফাইল বিভিন্ন ব্লক আকার ব্যবহার করতে পারি? ডিফল্ট আকার এর ব্লক 64 MB হয়। আপনি করতে পারা আপনার প্রয়োজনের উপর নির্ভর করে এটি পরিবর্তন করুন। আপনার প্রশ্ন আসছে হ্যাঁ আপনি একাধিক ফাইল তৈরি করতে পারেন বিভিন্ন দ্বারা ব্লক মাপ কিন্তু রিয়েল-টাইমে এটি ইচ্ছাশক্তি উৎপাদনের পক্ষে নয়।

অধিকন্তু, কেন HDFS ছোট ফাইলগুলিকে সর্বোত্তমভাবে পরিচালনা করে না?

সঙ্গে সমস্যা ছোট ফাইল এবং এইচডিএফএস প্রতি ফাইল , ডিরেক্টরি এবং ব্লক ইন HDFS হল নেমনোডের মেমরিতে একটি বস্তু হিসাবে উপস্থাপিত হয়, যার প্রতিটি 150 বাইট দখল করে, একটি নিয়ম হিসাবে। উপরন্তু, এইচডিএফএস নয় দক্ষতার সাথে অ্যাক্সেস করার জন্য প্রস্তুত ছোট ফাইল : এটা হয় প্রাথমিকভাবে বড় স্ট্রিমিং অ্যাক্সেসের জন্য ডিজাইন করা হয়েছে নথি পত্র.

কেন Hadoop ধীর?

ধীর প্রসেসিং স্পিড এই ডিস্কের জন্য সময় লাগে যার ফলে পুরো প্রক্রিয়াটি খুব বেশি হয় ধীর . যদি হাডুপ ছোট ভলিউমে তথ্য প্রক্রিয়াকরণ, এটা খুব ধীর তুলনামূলকভাবে এটি বড় ডেটা সেটের জন্য আদর্শ। হিসাবে হাডুপ মূলে ব্যাচ প্রসেসিং ইঞ্জিন আছে এর রিয়েল-টাইম প্রসেসিং এর গতি কম।

প্রস্তাবিত:

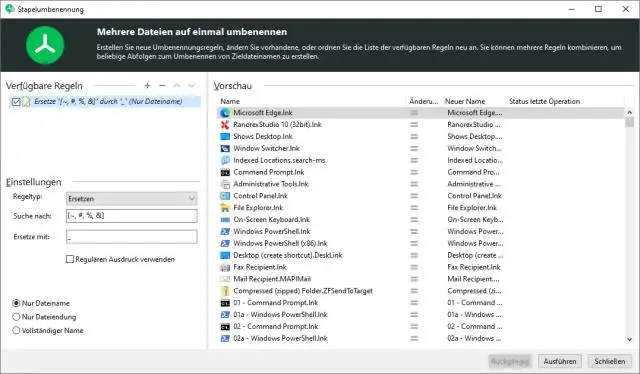

কোন অক্ষর আপনি একটি ফাইলের নাম ব্যবহার করতে পারবেন না?

আপনি একটি ফাইল নামের কোথাও নিম্নলিখিত অক্ষর ব্যবহার করতে পারবেন না: Tilde. সংখ্যা নিদর্শন. শতাংশ. অ্যাম্পারস্যান্ড। তারকাচিহ্ন ধনুর্বন্ধনী। ব্যাকস্ল্যাশ কোলন

আমি কিভাবে আমার OST ফাইলের আকার কমাতে পারি?

অফলাইন ফোল্ডার ফাইলের আকার হ্রাস করুন (.ost) আপনি রাখতে চান না এমন কোনো আইটেম মুছুন এবং তারপরে মুছে ফেলা আইটেম ফোল্ডারটি খালি করুন। টুল মেনুতে, অ্যাকাউন্ট সেটিংস ক্লিক করুন। তালিকায়, মাইক্রোসফ্ট এক্সচেঞ্জ সার্ভার নির্বাচন করুন এবং তারপরে পরিবর্তন ক্লিক করুন। আরো সেটিংস ক্লিক করুন

ম্যানিফেস্ট ফাইলের উদ্দেশ্য কি?

এটা উদ্দেশ্য কি? উদ্দেশ্য হল JAR ফাইল এবং এতে থাকা ক্লাসগুলি সম্পর্কে মেটাডেটা রাখা। মেটাডেটা বিভিন্ন জিনিসের জন্য ব্যবহার করা হয়, যার মধ্যে JAR এর উৎপত্তি ট্র্যাক করা, টেম্পারিং থেকে রক্ষা করা এবং এক্সিকিউটেবল JAR-এর জন্য প্রয়োজনীয় অতিরিক্ত তথ্য প্রদান করা।

আমি কীভাবে একটি ফোল্ডারের সমস্ত ফাইলের নাম নোটপ্যাডে অনুলিপি করব?

উইন্ডোজ 7-এ কমপক্ষে (Win8-এও কাজ করা উচিত), আপনি ফাইলগুলি নির্বাচন করতে পারেন, Shift টিপুন এবং ডান-ক্লিক করতে পারেন। এখন আপনি একটি নতুন Copy as path বিকল্প দেখতে পাবেন যেটিতে আপনি ক্লিক করতে পারেন এবং তারপর নোটপ্যাডে পাথগুলি পেস্ট করতে পারেন। একটি নোটপ্যাড খুলুন এবং নীচের লাইন টাইপ করুন। সঙ্গে এই ফাইল সংরক্ষণ করুন

সম্পর্কিত ফাইলের বিশাল সংগ্রহকে কী বলা হয়?

ফাইল সংগ্রহকে ডাটাবেস বলা হয়